La "muerte por calor" del universo se produce cuando el universo ha alcanzado un estado de máxima entropía. Esto sucede cuando toda la energía disponible (como la de una fuente caliente) se ha trasladado a lugares con menos energía (como una fuente más fría). Una vez que esto haya sucedido, no se podrá extraer más trabajo del universo.

- P. ¿En qué entropía es máxima?

- P. ¿Puede la entropía ser infinita?

- P. ¿Cuál es la fórmula para calcular la entalpía?

- P. ¿Qué es la entropía y la probabilidad?

- P. ¿Qué causa la entropía negativa?

- P. ¿Puede la entropía de Shannon ser negativa?

- P. ¿Cómo se utiliza la entropía en los árboles de decisión?

- P. ¿Qué nodo tiene la máxima entropía en el árbol de decisión?

- P. ¿Por qué son tan populares los clasificadores de árboles de decisión?

- P. ¿Cuál es la ventaja del árbol de decisiones?

- P. ¿Cómo contrarrestarás el sobreajuste en el árbol de decisiones?

- P. ¿El árbol de decisiones está supervisado o no supervisado?

P. ¿En qué entropía es máxima?

El principio de máxima entropía establece que la distribución de probabilidad que mejor representa el estado actual de conocimiento sobre un sistema es la que tiene mayor entropía, en el contexto de datos previos establecidos con precisión (como una proposición que expresa información comprobable).

P. ¿Puede la entropía ser infinita?

Como ningún sistema finito puede tener un número infinito de microestados, es imposible que la entropía del sistema sea infinita. De hecho, la entropía tiende hacia valores máximos finitos a medida que un sistema se acerca al equilibrio.

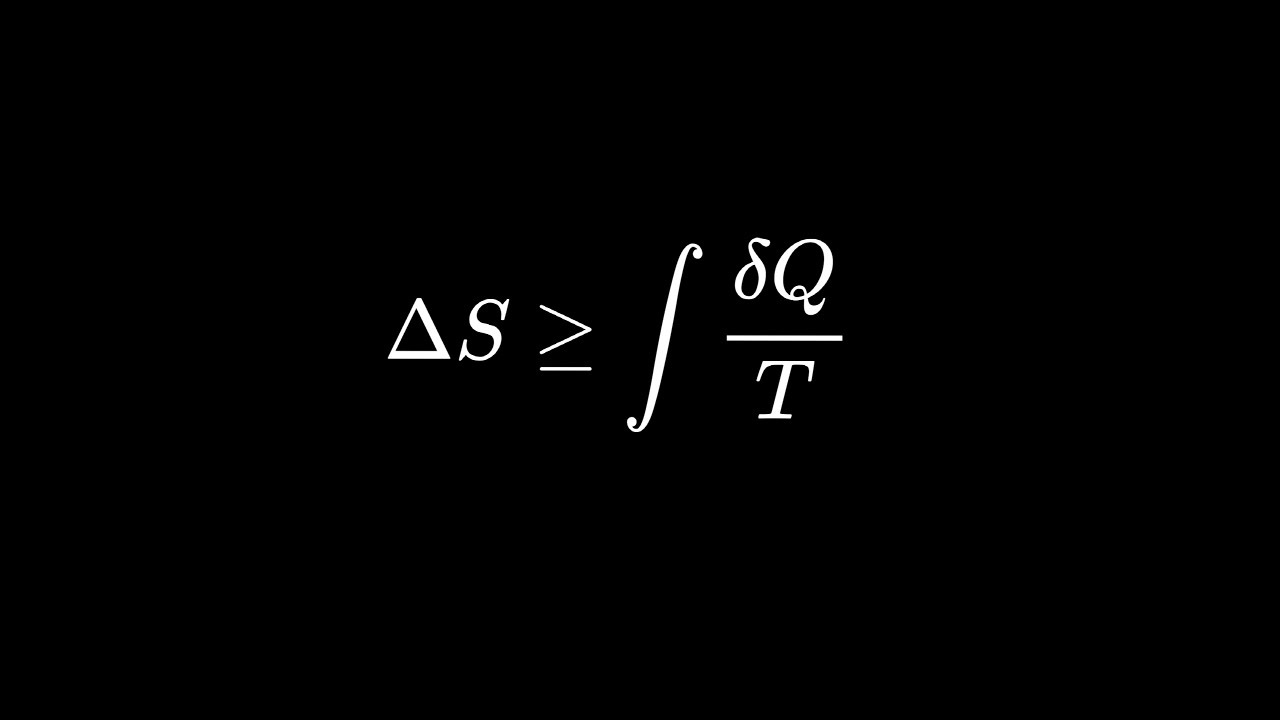

P. ¿Cuál es la fórmula para calcular la entalpía?

Si desea calcular el cambio de entalpía a partir de la fórmula de entalpía:

- Comience por determinar el cambio de volumen de su sustancia.

- Encuentre el cambio en la energía interna de la sustancia.

- Mida la presión del entorno.

- Ingrese todos estos valores a la ecuación ΔH = ΔQ + p * ΔV para obtener el cambio en entalpía:

P. ¿Qué es la entropía y la probabilidad?

La entropía mide la cantidad esperada (es decir, promedio) de información transmitida al identificar el resultado de una prueba aleatoria. Esto implica que lanzar un dado tiene mayor entropía que lanzar una moneda porque cada resultado de un lanzamiento de dado tiene una probabilidad menor (aproximadamente ) que cada resultado de un lanzamiento de moneda ( ).

P. ¿Qué causa la entropía negativa?

Un cambio negativo en la entropía indica que el desorden de un sistema aislado ha disminuido. Por ejemplo, la reacción por la cual el agua líquida se congela y forma hielo representa una disminución aislada de la entropía porque las partículas líquidas están más desordenadas que las sólidas.

P. ¿Puede la entropía de Shannon ser negativa?

La entropía de Shannon de la distribución exponencial puede ser negativa. y puede tomar valores negativos para muchos valores de la media μ!.

P. ¿Cómo se utiliza la entropía en los árboles de decisión?

El algoritmo ID3 utiliza entropía para calcular la homogeneidad de una muestra. Si la muestra es completamente homogénea la entropía es cero y si la muestra está dividida equitativamente tiene entropía uno. La ganancia de información se basa en la disminución de la entropía después de dividir un conjunto de datos según un atributo.

P. ¿Qué nodo tiene la máxima entropía en el árbol de decisión?

La entropía es más baja en los extremos, cuando la burbuja no contiene instancias positivas o solo contiene instancias positivas. Es decir, cuando la burbuja es pura, el desorden es 0. La entropía es mayor en el medio cuando la burbuja se divide uniformemente entre instancias positivas y negativas.

P. ¿Por qué son tan populares los clasificadores de árboles de decisión?

¿Por qué son tan populares los clasificadores de árboles de decisión? La construcción de árboles de decisión no implica ningún conocimiento del dominio ni establecimiento de parámetros y, por lo tanto, es apropiada para el descubrimiento de conocimientos exploratorios. Los árboles de decisión pueden manejar datos multidimensionales.

P. ¿Cuál es la ventaja del árbol de decisiones?

Una ventaja significativa de un árbol de decisión es que obliga a considerar todos los resultados posibles de una decisión y traza cada camino hasta una conclusión. Crea un análisis integral de las consecuencias a lo largo de cada rama e identifica nodos de decisión que necesitan un análisis más detallado.

P. ¿Cómo contrarrestarás el sobreajuste en el árbol de decisiones?

aumento del error del equipo de prueba. Existen varios enfoques para evitar el sobreajuste al crear árboles de decisión. Podas previas que dejen de crecer el árbol antes, antes de que clasifique perfectamente el conjunto de formación. Postpoda que permite al árbol clasificar perfectamente el conjunto de entrenamiento, para luego pospoda el árbol.

P. ¿El árbol de decisiones está supervisado o no supervisado?

Los árboles de decisión son un método de aprendizaje supervisado no paramétrico que se utiliza tanto para tareas de clasificación como de regresión. Los modelos de árbol en los que la variable objetivo puede tomar un conjunto discreto de valores se denominan árboles de clasificación.

En termodinámica, la entropía (simbolizada como S) es una magnitud física para un sistema termodinámico en equilibrio. Mide el número de microestados compati…

No Comments